今天在告警信息中查看到了hardware slow_down DA:00.0,第一反应是硬件降速了,对于目前集群情况来说第一时间想到的就是GPU降速

我们可以根据提供的bus_id进行检查看看是什么设备

lspci | grep DA:00.0可以明显看到是GPU,那我们接下来可以看看是哪张卡降速了

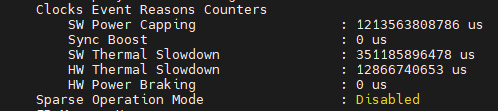

nvidia-smi -q

我们翻到DA:00.0这张卡可以看到了硬件降速,12866740653 us约等于3.57小时,这样就从GPU记录的信息来看,该GPU历史上确实发生过热降速,累计约3.57小时。

另外顺便列举下GPU降速类型有以下几种

| 降速类型 | 原因 | 解决方案 |

|---|---|---|

| HW Thermal Slowdown | 温度过高 | 1. 检查散热系统 2. 清理风扇和散热片 3. 改善机柜通风 4. 降低环境温度 |

| HW Power Brake Slowdown | 功耗超限 | 1. 检查电源供应 2. 降低GPU功耗限制 3. 优化应用负载 |

| SW Thermal Slowdown | 软件温控 | 1. 检查驱动温控设置 2. 调整温度阈值 |

根据上述列举我们是温度过高导致的降速,根据对应的解决方案实施再进行观察下。

然后查看GPU是否降频,我们也需要进行检查下

nvidia-smi -i 0 --query-gpu=index,utilization.gpu,temperature.gpu,power.draw,clocks.gr,clocks.mem,clocks_throttle_reasons.hw_slowdown,clocks_throttle_reasons.hw_thermal_slowdown,clocks_throttle_reasons.sw_power_cap,clocks_throttle_reasons.hw_power_brake_slowdown,clocks_throttle_reasons.gpu_idle,clocks_throttle_reasons.applications_clocks_setting --format=csv -lms 1同时也需要确保GPU的当前的性能模式是P0

nvidia-smi -q | grep 'Performance State'内容版权声明:除非注明,否则皆为本站原创文章。

转载注明出处:https://sulao.cn/post/1153

评论列表