在logstash处理filebeat收集的日志数据以后我们可以发现logstash解析以后有一个@timestamp时间,然后而这个时间跟我们grok解析日志以后里面所包含的时间不是一致的,logstash收集日志的@...

考虑到发布和订阅消息的实时性问题,有时需要消费者重新消费之前的历史日志消息,所以后面肯定需要使用kafka替换掉原来使用的redis,所以这里暂时先mark下logstash清洗过滤日志以后发布到kafka主题中的方式将...

自己在测试环境中尝试编写一些简单的日志规则,于是拿mongodb的日志进行测试,整体的ELK环境这里不再讲了,主要从客户端的filebeat开始我们去mongodb服务器上安装filebeatwget https://a...

之前配置的ELK中,kibana直接访问5601端口即可登陆,但是我们的日志管理系统是暴露在公网上的,这样是非常不安全的,所以我们要给kibana的登陆增加认证功能,需要口令来登陆ELK中X-Pack安全性使你能够轻松地...

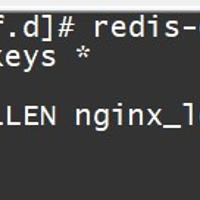

我们之前写过一篇logstash收集数据输出到redis的笔记:https://sulao.cn/post/736,可能我们有一点顾虑,redis单个key的最大value大小为512M,在生产环境中收集集群机器的日志数...

filters/mutate 插件是 Logstash 另一个重要插件。它提供了丰富的基础类型数据处理能力。包括类型转换,字符串处理和字段处理等。类型转换类型转换是 filters/mutate 插件最初诞生时的唯一功能...

logstash调用系统执行命令exec的方法比较简单,调用exec命令可以直接调用系统脚本或者命令,处理的方法可以变的更加灵活例如我们在zabbix的邮件报警笔记中使用到了python脚本进行报警,通过稍作修改,也可以...

之前的学习都是logstash收集过滤的日志再次传递到ES中进行存储使用,在实际的工作中有些日志我们是不需要存储到DB中,而是直接收集打包存储到硬盘logstash中的output/file插件可以实现这个功能,使用例子...

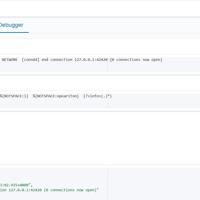

ELK中我们通常是使用logstash收集到日志然后直接提交到ES中进行存储,当在大量日志的场景下,当存储已经跟不上收集的速度是我们需要使用队列来进行顺序存储,redis在项目中作为存储中间件,下面我们就在之前的笔记的基...

Logstash是Elastic stack 中的一个开源组件,其不仅能够对日志进行抓取收集,还能对抓取的日志进行过滤输出。Logstash的过滤插件有多种,如:grok、date、json、geoip等等。其中最为常用...