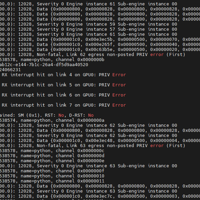

这两天客户反馈程序跑到一半异常了,然后查看dmesg日志有打印有很多nvswitch的12028的致命错误信息,还有Xid 94 和 137的错误信息,相关Xid 错误信息可以在这个笔记里面进行查询核对:https://...

在做具体操作之前我们来了解下ACS,ACS是指PCI访问控制服务(PCI Access Control Service),是一种在启用VT-d(I/O虚拟化技术)时用于控制PCI设备访问权限的机制,属于BIOS芯片组配置...

nvidia的nvidia-peermem模块通常是配合驱动参数NVreg_RegistryDwords一起使用,作用是强制启用 GPU 对等映射,让GPU 间通信直接进行,避免CPU的介入从而降低CPU负载,且不占用主...

目前交付场景中我们常做一些内核和驱动参数优化,主要有内核加载nvidia_peermem,还有一些驱动调节参数,NVreg_EnableStreamMemOPs, NVreg_RegistryDwords,NVreg_E...

前天有台客户的服务器自动重启了,接到通知后我对服务器进行了排查分析,顺便记录下这次排查的过程,登录重启的服务器我们首先就是需要确认的是重启的时间journalctl --list-boots 0 46204d44f10a...

今天客户有块磁盘识别容量大小异常,于是尝试关机插拔磁盘试试,插拔完重启使用mount -a进行挂载的时候出现了以下报错mount: /mnt/data1: wrong fs type, bad option, bad s...

周末遇到一个问题,就是由于我ubuntu22.04安装的内核版本比较老,是5.15.0-88-generic这个版本,然后发现linux-libc-dev这个软件被升级了,我们使用命令查看跟内核版本不一致,这个包是lin...

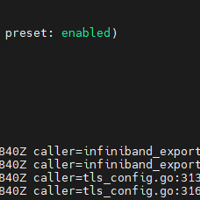

最近监控有需求要监控计算网络,也就是infiniband网络,目前已有dcgm-exporter和node-exporter,就看看infiniband是否也有类似的expoter可以用来监控,于是查了下InfiniBa...

nvidia-smi 是 NVIDIA 提供的 GPU 管理工具,用于监控 GPU 使用情况和调整 GPU 状态。它支持 Linux 和 Windows 系统,安装 NVIDIA 驱动后即可使用。我们可以通过nvidia...