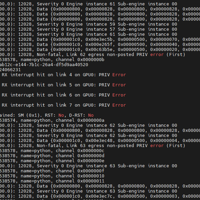

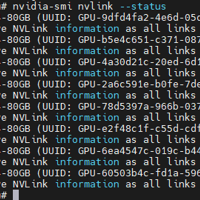

这两天客户反馈程序跑到一半异常了,然后查看dmesg日志有打印有很多nvswitch的12028的致命错误信息,还有Xid 94 和 137的错误信息,相关Xid 错误信息可以在这个笔记里面进行查询核对:https://...

nvidia的nvidia-peermem模块通常是配合驱动参数NVreg_RegistryDwords一起使用,作用是强制启用 GPU 对等映射,让GPU 间通信直接进行,避免CPU的介入从而降低CPU负载,且不占用主...

目前交付场景中我们常做一些内核和驱动参数优化,主要有内核加载nvidia_peermem,还有一些驱动调节参数,NVreg_EnableStreamMemOPs, NVreg_RegistryDwords,NVreg_E...

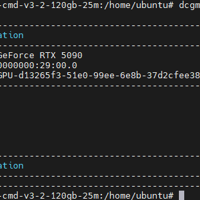

DCGM (Data Center GPU Manager) 是 NVIDIA 提供的一个用于数据中心 GPU 管理和监控的工具集,提供了以下功能1.GPU 行为监控 2.GPU 配置管理 3.GPU 策略监督 4.GP...

Xid 消息是来自 NVIDIA 驱动程序的错误报告,会打印到操作系统的内核日志或事件日志中。Xid 消息表明发生了普遍的 GPU 错误,通常是因为驱动程序错误地对 GPU 进行了编程,或者是因为发送给 GPU 的指令出...

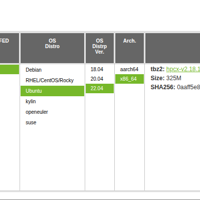

NVIDIA HPC SDK是一套综合的编译器、库和工具,用于GPU加速HPC建模和仿真应用。随着对运行Linux的NVIDIA gpu和x86-64、OpenPOWER或Arm cpu的支持,NVIDIA HPC SD...

NVIDIA HPC-X 是一个综合软件包,包括消息传递接口 (MPI)、对称分层内存 (SHMEM) 和分区全局地址空间 (PGAS) 通信库以及各种加速包。这个功能齐全、经过测试和打包的工具包使 MPI 和 SHME...