AI训练程序也是是导致GPU异常的最常见原因之一。训练深度神经网络对GPU施加的压力是巨大且持续的,远超大多数图形渲染或通用计算任务。1.显存耗尽 (Out of Memory - OOM)这是最常见的的原因。当训练程序...

CUDA驱动程序提供向后兼容的API。因此,新的NVIDIA驱动程序将始终与旧的CUDA工具包一起工作。这里记录了CUDA的这种行为。然而,每个CUDA工具包都需要最低版本的NVIDIA驱动程序。因此,当使用诸如NVID...

计算能力(CC)定义了每个NVIDIA GPU架构的硬件特性和支持的指令。在下表中查找您的GPU的计算能力。对于传统GPU,请参考传统CUDA GPU计算能力。有些卡没有找到,但是你可以通过命令查询卡的计算力,使用如下命...

之前我们有学习过nccl的部署和ncc-test工具的使用,我们可以查看之前的笔记:https://sulao.cn/post/988今天我们就根据nccl官网文档https://docs.nvidia.com/deep...

我们通常看到发布的开源模型都会有写10b,17b,100b等等这些数字,这些都是指的模型参数规模,现在大模型参数从原来的亿级暴增至几百亿,这些由于现在gpu性能的大幅提升以及应用对模型的性能需求,导致了参数规模爆发式增长...

在Linux系统中,load和idle是衡量CPU忙闲状态的两个重要指标,它们从不同的角度反映了CPU的使用情况。1.loadload是指系统在特定时间间隔内运行的平均进程数。它反映了CPU的工作负荷,具体数值可以从/p...

模型内部的结构和组成因类型而异,但以常见的深度学习模型(如神经网络)为例,其核心组成部分和机制可以总结如下:1.基本结构组件输入层(Input Layer):接收原始数据(如文本、图像、数值),并将其转换为模型可处理的格...

大模型通常指的大语言模型,这个大主要体现在规模上,一般指的参数规模和包含更复杂的神经网络架构,目前模型主要有包括Transformer、卷积神经网络(CNN)和循环神经网络(RNN)这几种模型架构。一般模型训练是为了通过...

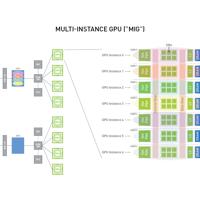

MIG通过虚拟地将单个物理GPU划分为更小的独立实例,这项技术涉及GPU虚拟化,GPU的资源,包括CUDA内核和内存,被分配到不同的实例。这些实例彼此隔离,确保在一个实例上运行的任务不会干扰其他实例。使用MIG,每个实例...