ELK中修改默认的@timestamp时间为日志生成时间

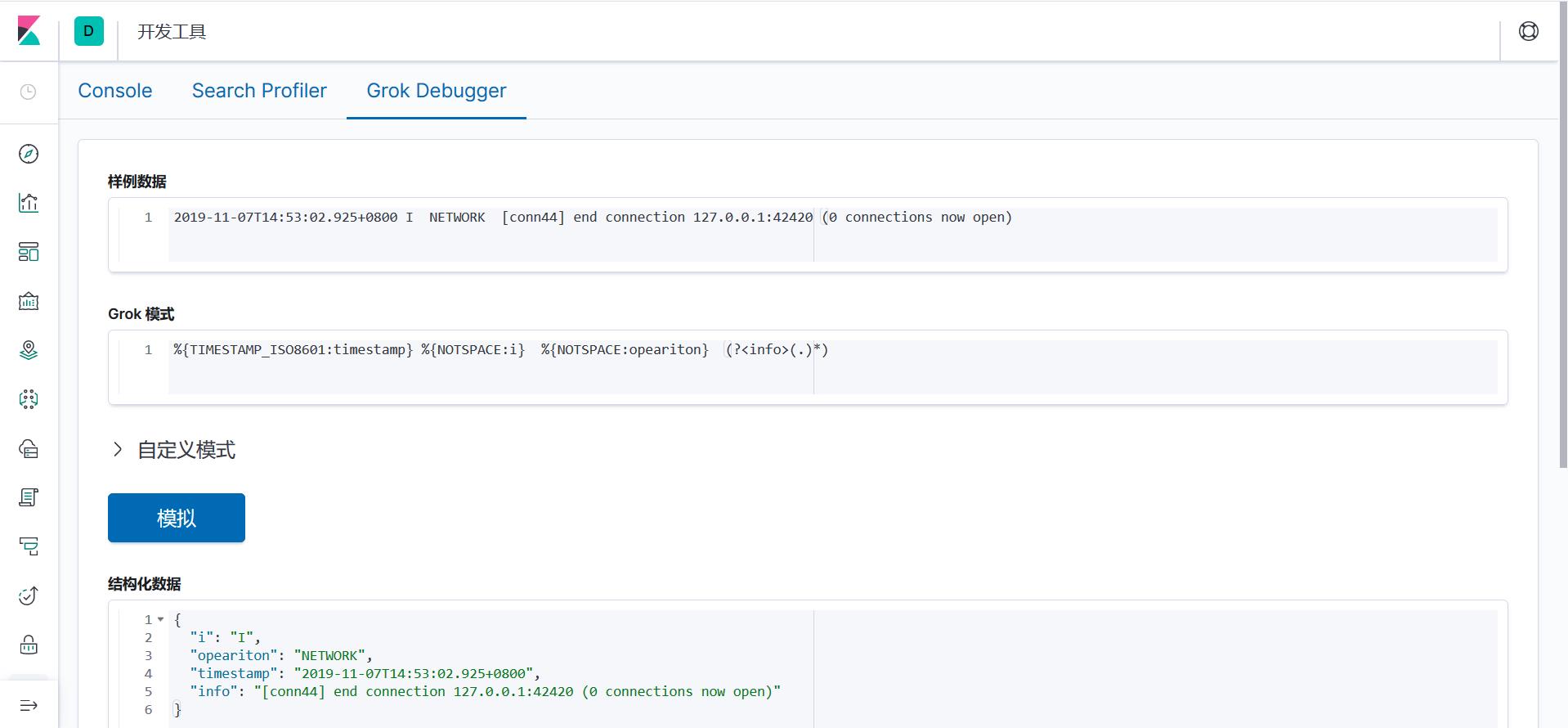

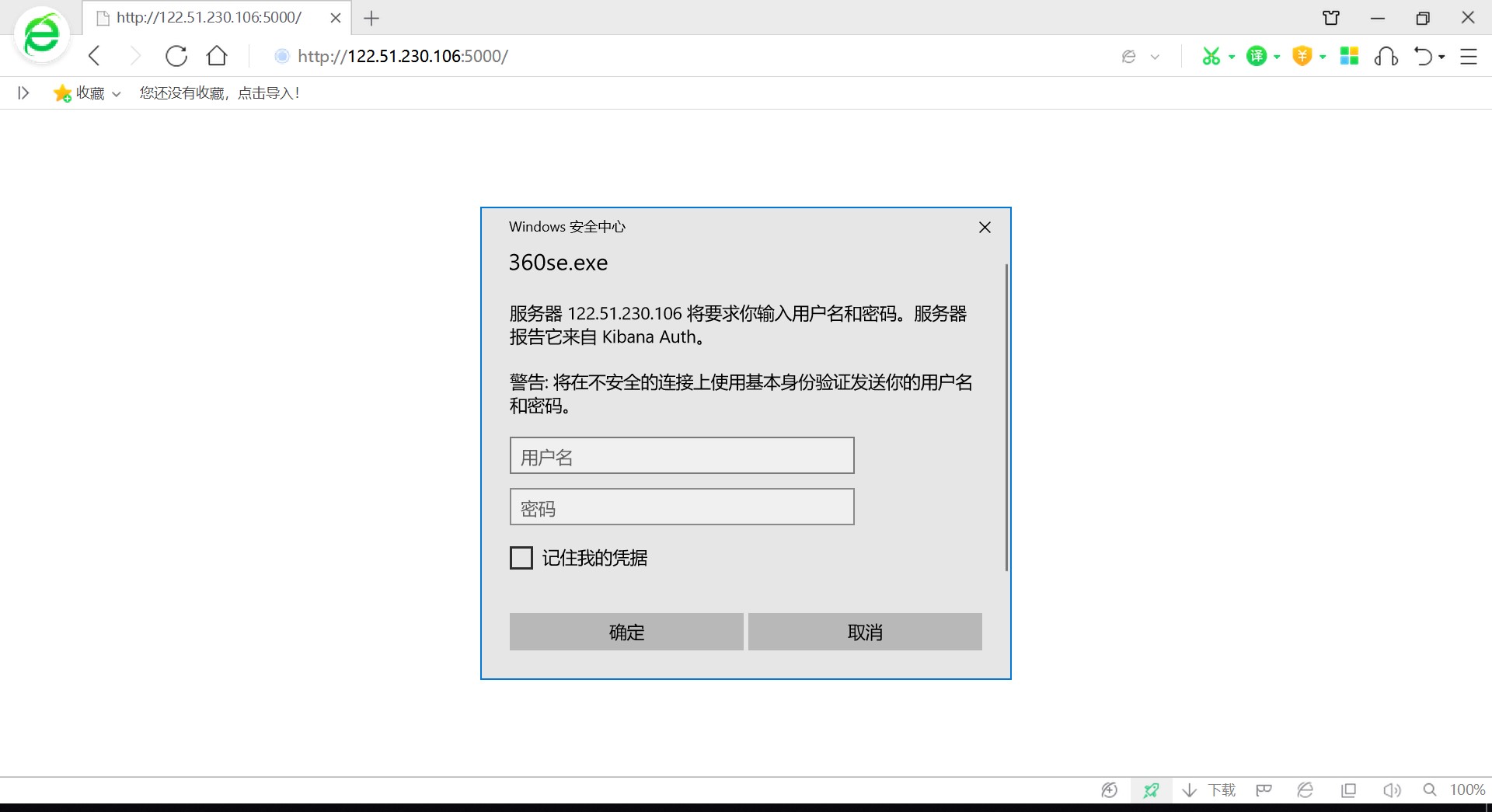

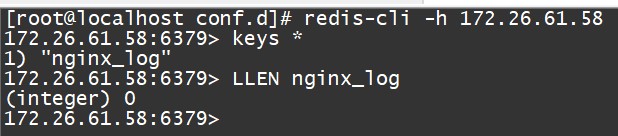

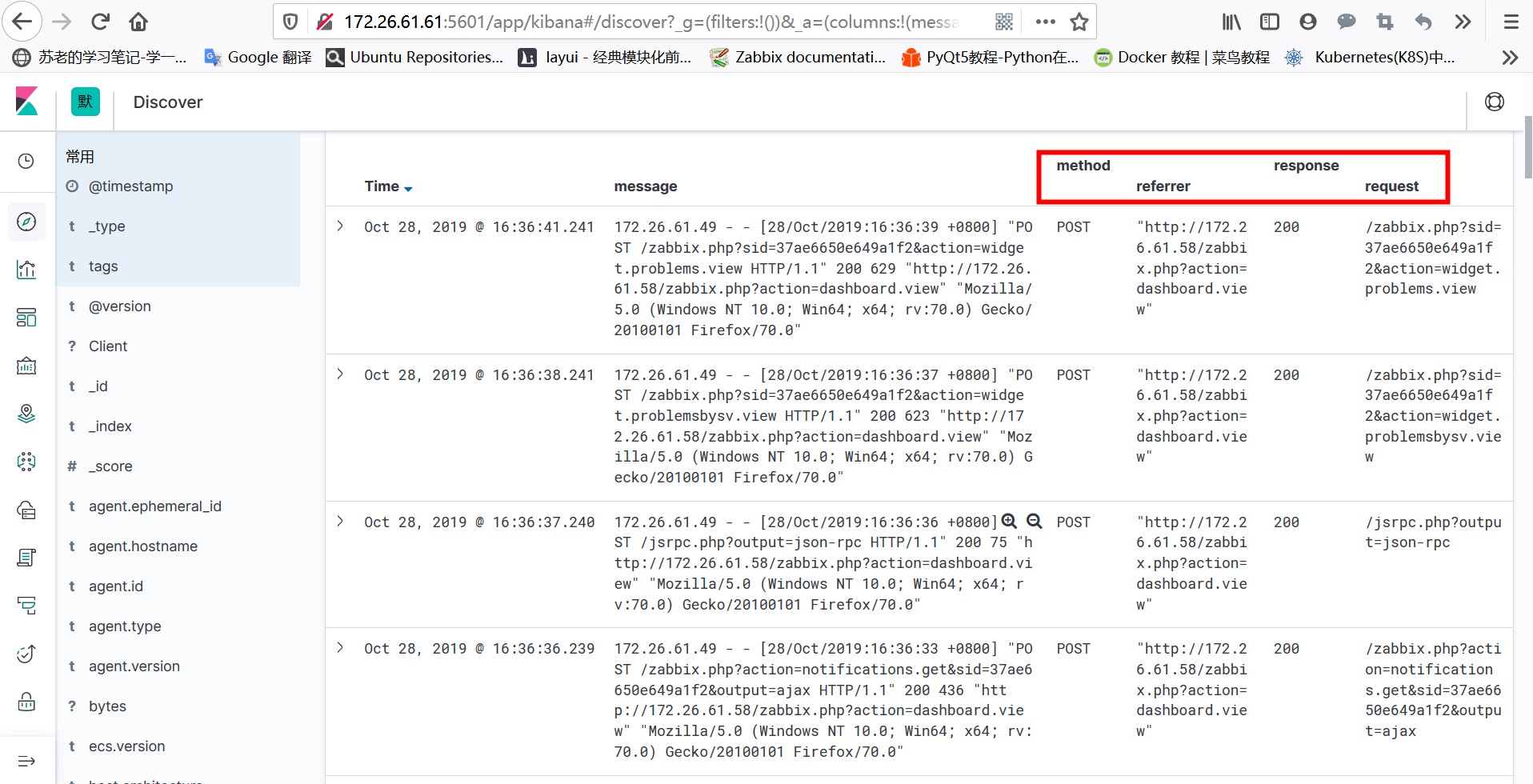

在logstash处理filebeat收集的日志数据以后我们可以发现logstash解析以后有一个@timestamp时间,然后而这个时间跟我们grok解析日志以后里面所包含的时间不是一致的,logstash收集日志的@timestamp时间是日志采集时间,而且使用的是UTC时区,相对于北京时间会晚8个小时,我们一般都不太关注日志采集时间,而是更加关注日志生成时间,所以我们需要将@timestamp字段的时间改写成日志生成时间我们这里还是用之前收集mongodb日志的例子来继续学习下如何改写@timestamp字段的时间,mongodb收集日志的方式还是...